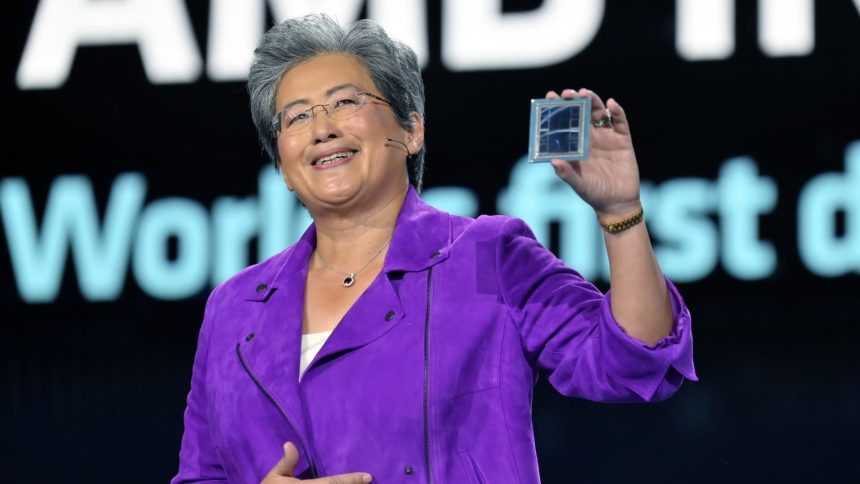

تعرض ليزا سو شريحة AMD Instinct MI300 أثناء إلقاء خطاب رئيسي في معرض CES 2023 في لاس فيغاس، نيفادا، 4 يناير 2023.

ديفيد بيكر | صور جيتي

ميتا، أوبن إيه آي، و مايكروسوفت قال في ان أيه إم دي في حدث المستثمرين يوم الأربعاء، سيستخدمون أحدث شريحة AI من AMD، Instinct MI300X. إنها أكبر علامة حتى الآن على أن شركات التكنولوجيا تبحث عن بدائل لمعالجات الرسومات Nvidia باهظة الثمن والتي كانت ضرورية لإنشاء ونشر برامج الذكاء الاصطناعي مثل ChatGPT من OpenAI.

إذا كانت أحدث شرائح AMD المتطورة جيدة بما يكفي لشركات التكنولوجيا ومقدمي الخدمات السحابية الذين يبنون ويخدمون نماذج الذكاء الاصطناعي عندما يبدأ الشحن في أوائل العام المقبل، فقد يؤدي ذلك إلى خفض تكاليف تطوير نماذج الذكاء الاصطناعي ووضع ضغوط تنافسية على نمو مبيعات شرائح الذكاء الاصطناعي المتزايد من Nvidia. .

وقالت ليزا سو، الرئيس التنفيذي لشركة AMD، يوم الأربعاء: “كل الاهتمام منصب على الحديد الكبير ووحدات معالجة الرسوميات الكبيرة للسحابة”.

تقول AMD أن جهاز MI300X يعتمد على بنية جديدة، والتي غالبًا ما تؤدي إلى مكاسب كبيرة في الأداء. الميزة الأكثر تميزًا هي أنه يحتوي على 192 جيجابايت من نوع الذاكرة المتطور وعالي الأداء المعروف باسم HBM3، والذي ينقل البيانات بشكل أسرع ويمكن أن يناسب نماذج الذكاء الاصطناعي الأكبر حجمًا.

قام Su مباشرة بمقارنة جهاز MI300X والأنظمة المبنية معه بوحدة معالجة الرسوميات الرئيسية التي تعمل بالذكاء الاصطناعي من Nvidia، H100.

وقال سو: “ما يفعله هذا الأداء هو أنه يترجم مباشرة إلى تجربة مستخدم أفضل”. “عندما تطلب من عارضة أزياء شيئًا ما، فإنك ترغب في الرد عليه بشكل أسرع، خاصة عندما تصبح الإجابات أكثر تعقيدًا.”

السؤال الرئيسي الذي يواجه AMD هو ما إذا كانت الشركات التي كانت تعتمد على Nvidia ستستثمر الوقت والمال لإضافة مورد GPU آخر. وقال سو: “إن اعتماد AMD يتطلب العمل”.

أخبرت AMD يوم الأربعاء المستثمرين والشركاء بأنها قامت بتحسين مجموعة برامجها المسماة ROCm للتنافس مع برنامج CUDA القياسي في الصناعة من Nvidia، مما يعالج العيب الرئيسي الذي كان أحد الأسباب الرئيسية التي تجعل مطوري الذكاء الاصطناعي يفضلون Nvidia حاليًا.

سيكون السعر مهمًا أيضًا. لم تكشف AMD عن أسعار MI300X يوم الأربعاء، لكن شريحة Nvidia يمكن أن تكلف حوالي 40 ألف دولار لشريحة واحدة، وأخبر سو المراسلين أن شريحة AMD يجب أن تكون تكلفتها أقل للشراء والتشغيل من شريحة Nvidia من أجل إقناع العملاء بشرائها.

من يقول أنهم سيستخدمون MI300X؟

مسرع AMD MI300X للذكاء الاصطناعي.

قالت AMD يوم الأربعاء إنها قامت بالفعل بتسجيل بعض الشركات المتعطشة لوحدات معالجة الرسومات لاستخدام الشريحة. كانت Meta وMicrosoft أكبر مشتريين لوحدات معالجة الرسوميات Nvidia H100 في عام 2023، وفقًا لتقرير حديث صادر عن شركة الأبحاث Omidia.

قالت Meta إنها ستستخدم وحدات معالجة الرسومات MI300X لأعباء عمل استدلال الذكاء الاصطناعي مثل معالجة ملصقات الذكاء الاصطناعي وتحرير الصور وتشغيل مساعدها.

وقال كيفن سكوت، المدير التنفيذي للتكنولوجيا في مايكروسوفت، إن الشركة ستوفر إمكانية الوصول إلى شرائح MI300X من خلال خدمة الويب Azure الخاصة بها.

وحيستستخدم سحابة s أيضًا الرقائق.

قالت OpenAI إنها ستدعم وحدات معالجة الرسوميات AMD في أحد منتجاتها البرمجية، والتي تسمى Triton، وهي ليست نموذجًا لغويًا كبيرًا مثل GPT ولكنها تُستخدم في أبحاث الذكاء الاصطناعي للوصول إلى ميزات الرقائق.

لا تتوقع AMD مبيعات ضخمة للرقاقة حتى الآن، وتتوقع فقط حوالي 2 مليار دولار من إجمالي إيرادات وحدة معالجة الرسومات لمراكز البيانات في عام 2024. وقد أبلغت Nvidia عن أكثر من 14 مليار دولار من مبيعات مراكز البيانات في الربع الأخير وحده، على الرغم من أن هذا المقياس يتضمن شرائح أخرى غير وحدات معالجة الرسومات.

ومع ذلك، تقول AMD إن إجمالي سوق وحدات معالجة الرسومات المدعمة بالذكاء الاصطناعي قد يرتفع إلى 400 مليار دولار على مدى السنوات الأربع المقبلة، وهو ما يضاعف توقعات الشركة السابقة. يوضح هذا مدى ارتفاع التوقعات وكيف أصبحت رقائق الذكاء الاصطناعي المتطورة مرغوبة – ولماذا تركز الشركة الآن اهتمام المستثمرين على خط الإنتاج.

واقترح سو أيضًا للصحفيين أن AMD لا تعتقد أنها بحاجة إلى التغلب على Nvidia لتحقيق أداء جيد في السوق.

وقال سو للصحفيين، في إشارة إلى سوق شرائح الذكاء الاصطناعي: “أعتقد أنه من الواضح أن نقول إن إنفيديا يجب أن تكون الغالبية العظمى من ذلك الآن”. “نعتقد أنه قد يصل إلى أكثر من 400 مليار دولار في عام 2027. ويمكننا الحصول على جزء كبير من ذلك.”