جنسن هوانغ، رئيس Nvidia، يحمل وحدة المعالجة المركزية ذات الشريحة الفائقة Grace hopper المستخدمة في الذكاء الاصطناعي التوليدي في العرض التقديمي الرئيسي لـ Supermicro خلال Computex 2023.

وليد برازق | صاروخ لايت | صور جيتي

نفيديا كشفت يوم الاثنين النقاب عن H200، وهي وحدة معالجة رسومية مصممة لتدريب ونشر أنواع نماذج الذكاء الاصطناعي التي تدعم طفرة الذكاء الاصطناعي التوليدي.

وحدة معالجة الرسوميات الجديدة عبارة عن ترقية من H100، وهي الشريحة التي استخدمتها OpenAI لتدريب نموذج اللغة الكبير الأكثر تقدمًا، GPT-4. تتنافس الشركات الكبرى والشركات الناشئة والهيئات الحكومية للحصول على إمدادات محدودة من الرقائق.

تتكلف شرائح H100 ما بين 25 ألف دولار و40 ألف دولار، وفقًا لتقدير ريموند جيمس، وهناك حاجة إلى آلاف منها للعمل معًا لإنشاء أكبر النماذج في عملية تسمى “التدريب”.

أدت الإثارة حول وحدات معالجة الرسومات المدعمة بالذكاء الاصطناعي من Nvidia إلى زيادة أسهم الشركة، والتي ارتفعت بأكثر من 230٪ حتى الآن في عام 2023. وتتوقع Nvidia إيرادات تبلغ حوالي 16 مليار دولار للربع الثالث المالي، بزيادة 170٪ عن العام الماضي.

يتمثل التحسين الرئيسي في H200 في أنه يشتمل على 141 جيجابايت من ذاكرة “HBM3” من الجيل التالي والتي ستساعد الشريحة على أداء “الاستدلال” أو استخدام نموذج كبير بعد تدريبها على إنشاء نصوص أو صور أو تنبؤات.

وقالت نفيديا إن H200 سيولد مخرجات أسرع بمرتين تقريبًا من H100. هذا يعتمد على اختبار باستخدام ميتا اللاما 2 ماجستير.

وسيتنافس جهاز H200، الذي من المتوقع أن يتم شحنه في الربع الثاني من عام 2024، مع وحدة معالجة الرسوميات MI300X من AMD. أيه إم دي تحتوي الشريحة، المشابهة لـ H200، على ذاكرة إضافية مقارنة بأسلافها، مما يساعد على احتواء النماذج الكبيرة على الأجهزة لتشغيل الاستدلال.

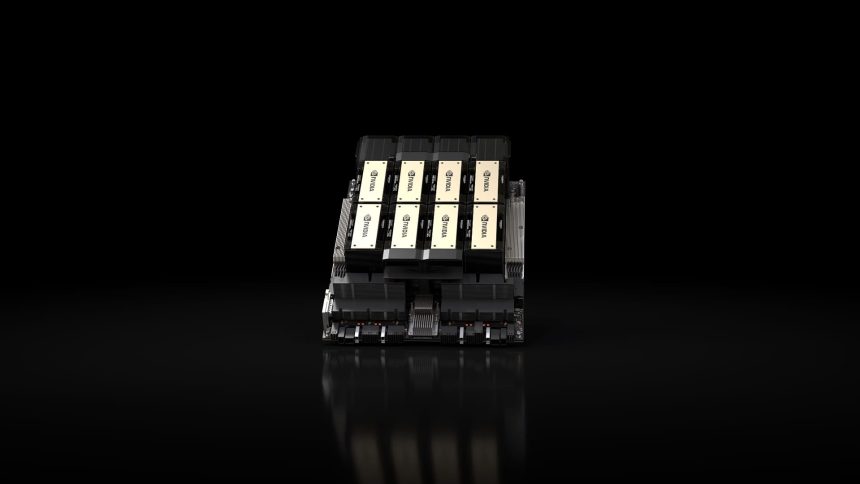

شرائح Nvidia H200 في نظام Nvidia HGX ذو ثمانية وحدات معالجة رسومية.

نفيديا

وقالت Nvidia إن H200 سيكون متوافقًا مع H100، مما يعني أن شركات الذكاء الاصطناعي التي تتدرب بالفعل على النموذج السابق لن تحتاج إلى تغيير أنظمة الخادم أو البرامج الخاصة بها لاستخدام الإصدار الجديد.

تقول Nvidia إنها ستكون متاحة في تكوينات خادم رباعية GPU أو ثمانية GPU على أنظمة HGX الكاملة للشركة، وكذلك في شريحة تسمى GH200، والتي تربط وحدة معالجة الرسوميات H200 بمعالج قائم على Arm.

ومع ذلك، قد لا يحمل H200 تاج أسرع شريحة Nvidia AI لفترة طويلة.

في حين أن شركات مثل نفيديا تقدم العديد من التكوينات المختلفة لرقائقها، فإن أشباه الموصلات الجديدة غالبا ما تتخذ خطوة كبيرة إلى الأمام كل عامين تقريبا، عندما تنتقل الشركات المصنعة إلى بنية مختلفة تفتح مكاسب أداء أكثر أهمية من إضافة الذاكرة أو غيرها من التحسينات الأصغر. يعتمد كل من H100 وH200 على بنية Nvidia’s Hopper.

في أكتوبر، أخبرت Nvidia المستثمرين أنها ستنتقل من إيقاع معماري مدته سنتان إلى نمط إصدار مدته عام واحد بسبب ارتفاع الطلب على وحدات معالجة الرسومات الخاصة بها. وعرضت الشركة شريحة تقترح أنها ستعلن وتطلق شريحة B100 الخاصة بها، استنادًا إلى بنية Blackwell القادمة، في عام 2024.

يشاهد: نحن مؤمنون بشدة باتجاه الذكاء الاصطناعي الذي سيبدأ في العام المقبل

لا تفوّت هذه القصص من CNBC PRO: